在企业招聘中,HR 常因主观认知偏差(如首因效应、光环效应)导致候选人评估失准,既可能遗漏优质人才,也可能因偏见影响招聘公平性。而 AI 面试系统的出现,正通过标准化流程与数据化评估,逐步解决这一痛点。

本文将从 AI 面试系统的功能特性出发,拆解其减少招聘偏见、提升评估客观性的具体逻辑,为 HR 优化招聘流程提供实用参考,帮助企业建立更公平、精准的人才选拔机制。

_09-2-1024x576.jpg)

01 统一评估标准:AI 面试系统减少偏见的基础

招聘偏见的核心成因之一,是人工面试中评估标准模糊且易受个人主观影响 —— 不同面试官对 “沟通能力”“逻辑思维” 的定义不同,评分尺度也存在差异。而 AI 面试系统会先基于岗位需求构建标准化评估框架,将抽象的能力要求(如 “客户服务意识”“问题解决能力”)拆解为可量化的维度(如回答逻辑连贯性、问题响应速度、核心信息匹配度)。

系统会根据岗位 JD 自动提取关键要求,结合行业通用胜任力模型,为每个评估维度设定明确标准(例如技术岗侧重 “代码逻辑描述准确性”,客服岗侧重 “情绪稳定性与解决方案提供能力”)。所有候选人面对相同的评估维度与评分规则,避免了因面试官个人经验、偏好导致的标准波动,从源头减少偏见产生的可能。

02 多模态数据驱动:AI 面试系统提升评估客观性的核心

人工面试多依赖面试官对候选人语言表达、肢体动作的主观观察,易忽略关键信息或过度放大某一细节(如因候选人着装风格产生偏好)。AI 面试系统则通过多模态数据采集与分析,实现更客观的评估。

系统会同步采集候选人的语音、面部表情、语义内容等数据:通过语音分析判断回答的流利度、语调稳定性,辅助评估沟通自信度;通过面部识别捕捉微表情(如情绪波动时的自然反应),辅助判断抗压能力;通过自然语言处理拆解回答的语义逻辑,判断是否贴合岗位需求(如分析项目经验描述中 “角色”“成果”“问题解决方法” 的完整性)。

这些数据均通过算法客观分析,避免人工观察中的主观过滤,让评估结果更贴合候选人真实能力,而非面试官的直观印象。

03 流程自动化与可追溯:AI 面试系统规避偏见的保障

传统面试中,流程透明度低、记录不完整,若出现评估争议,难以追溯判断依据,也无法及时发现偏见问题。AI 面试系统则通过全流程自动化与数据留存,形成可追溯的评估闭环。

系统会自动记录面试全过程:从候选人进入面试间、回答问题,到 AI 生成评分报告,每一步操作与数据均实时存储。HR 可随时回看面试记录(如语音转写文本、关键表情片段),核对评分依据是否匹配实际表现;同时,系统会自动汇总所有候选人的评估数据,若某一维度评分出现异常波动(如对特定背景候选人评分普遍偏低),可及时排查是否存在模型偏差,进一步优化评估逻辑。

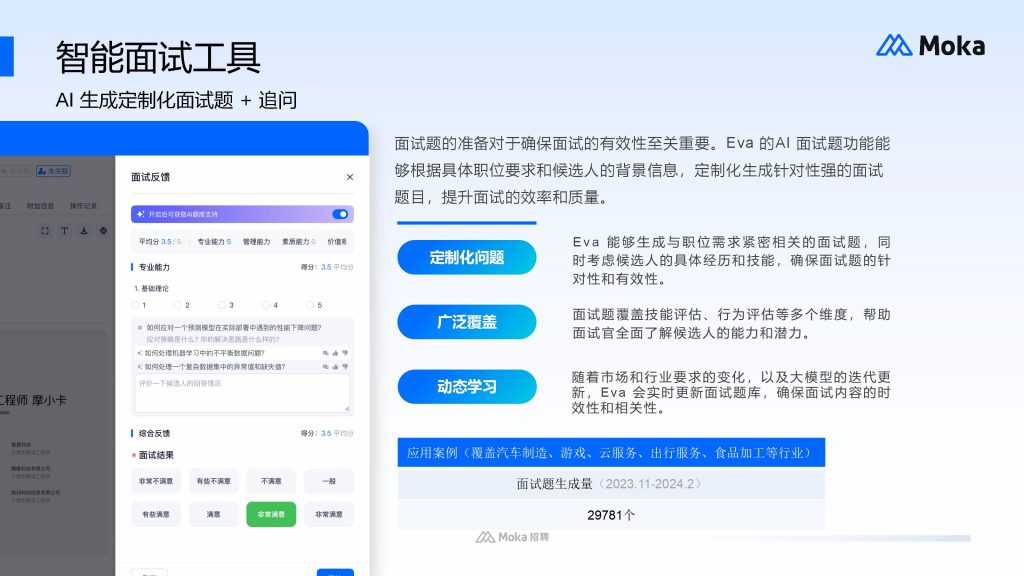

以 Moka 人力资源管理系统为例,其 AI 面试模块支持评估数据与企业人才库、人事管理模块打通,面试记录与评分可直接同步至后续入职、绩效环节,既保障流程透明,也为后续招聘优化提供数据支撑。

04 动态校准机制:AI 面试系统持续优化客观性的关键

即使初始评估框架标准化,随着企业业务变化、岗位需求调整,评估标准也需动态更新,否则可能产生新的 “隐性偏见”(如某一时期过度侧重某一能力,导致其他维度优秀的候选人被筛除)。AI 面试系统具备动态校准能力,可根据实际招聘效果持续优化评估逻辑。

系统会定期将候选人的面试评估结果与入职后的绩效数据对比:若某一评估维度的得分与实际工作表现关联度低(如 “学历背景” 评分高但绩效普通),会提示 HR 调整该维度的权重;若某类问题候选人普遍回答偏离岗位需求,会自动优化题库,确保评估内容与岗位实际需求匹配。

FAQ:AI 面试系统的评估结果是否会存在 “算法偏见”?

不会。正规 AI 面试系统会通过多重机制规避算法偏见:一方面,初始模型训练会采用多样化的候选人数据,避免因数据单一导致的偏差;另一方面,系统支持人工定期审核评估逻辑,若发现某一群体的评分存在异常,可及时调整算法参数,确保评估公平性。例如 Moka 的 AI 面试模块,会通过多维度数据交叉验证(如语音、语义、表情数据结合分析),进一步降低单一数据导致的判断偏差。

AI 面试系统通过统一标准、多模态数据驱动、流程可追溯、动态校准,减少招聘偏见并提升评估客观性,解决传统面试的主观判断问题。HR 在应用时,需优先选择支持标准化评估与数据追溯的系统,同时定期结合招聘效果校准评估逻辑。通过 AI 工具与人工判断的配合,可构建更公平、精准的招聘体系,帮助企业选拔真正适配的人才。