在企业招聘数字化转型中,招聘 AI 系统已成为 HR 的重要工具,但很多企业引入后却不知如何判断其实际效果 —— 是仅看简历筛选速度,还是要兼顾人才匹配精准度?若无法科学评估,不仅难以发挥系统价值,还可能造成资源浪费。

本文围绕 “招聘 AI 系统效果如何评估” 这一核心问题,从功能实用性、流程适配性、实际落地价值等维度,结合 HR 工作经验与系统应用逻辑,拆解评估框架与方法,帮助企业避开 “盲目用系统” 的误区,让招聘 AI 工具真正服务于招聘效率提升。

01 评估基础:招聘 AI 系统核心功能的落地有效性

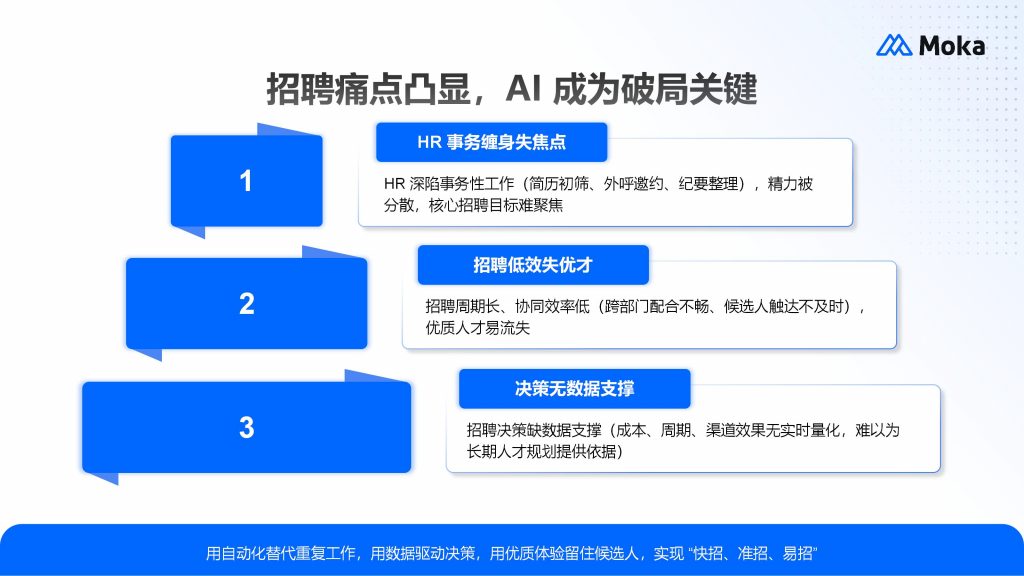

判断招聘 AI 系统效果,首先要回归其核心功能的实际表现,而非仅看 “技术噱头”。核心功能的有效性,直接决定系统能否解决招聘中的真实痛点。

从 HR 工作场景来看,招聘 AI 系统的核心功能通常包括简历智能解析、智能匹配、流程自动化等。评估时需关注:简历解析是否能准确提取非结构化信息(如项目经验、技能关键词),避免因信息提取错误导致优质候选人被遗漏;智能匹配是否能贴合企业岗位需求,而非机械匹配关键词 —— 比如技术岗是否能区分 “掌握 Python” 与 “熟练运用 Python 进行数据分析” 的差异;流程自动化是否能覆盖招聘关键节点(如自动发送面试邀约、同步进度),减少 HR 重复性工作。

以企业常用的简历筛选功能为例,有效的评估需观察:系统是否能根据 HR 预设的筛选规则(如工作年限、核心技能)精准过滤候选人,同时保留 “边缘符合” 的潜在人才供人工复核,而非一刀切式筛选。这一步的评估核心是 “功能是否贴合实际招聘流程”,而非追求 “全自动化”。

02 评估核心:招聘全流程的效率与适配性提升

招聘 AI 系统的核心价值之一是提升招聘效率,但效率提升不能只看 “速度”,还要看 “适配性”—— 即系统能否适配企业的招聘模式与岗位特性,避免 “为了快而快” 导致招聘质量下降。

评估效率时,需结合具体招聘场景:社招中,系统是否能快速整合多渠道简历(如招聘网站、内推、猎头),减少 HR 手动汇总的时间;校招中,面对大批量简历,系统是否能在短时间内完成初筛,同时保证筛选标准的一致性。而适配性评估则需关注:系统是否支持自定义招聘流程(如部分岗位需多轮技术面,系统能否灵活设置流程节点);对于非标岗位(如创意岗、管理岗),系统是否能提供 “AI 初筛 + 人工优筛” 的协同模式,而非完全依赖算法判断。

例如,某互联网企业引入招聘 AI 系统后,校招初筛时间从原本的 5 天缩短至 2 天,且通过系统预设的 “岗位胜任力模型”,初筛候选人与岗位的契合度较人工筛选提升 —— 这种 “速度 + 质量” 双提升,才是效率与适配性达标的体现。

03 评估关键:人才匹配与后续招聘转化的关联性

招聘 AI 系统的最终目标是帮助企业找到合适的人才,因此 “人才匹配精准度” 及 “后续招聘转化” 是评估效果的关键指标,需避免 “只看筛选环节,忽略后续结果” 的误区。

评估人才匹配精准度时,可关注两个维度:一是系统推荐的候选人中,进入面试环节的比例(即 “推荐通过率”),若推荐候选人多数无法通过业务部门初面,可能说明系统对岗位需求的理解存在偏差;二是候选人入职后的留存情况,若系统筛选的候选人入职 3 个月内离职率较高,需复盘系统匹配模型是否遗漏了 “文化适配性”“岗位稳定性” 等隐性需求。

此外,还需观察系统是否能辅助 HR 优化匹配逻辑 —— 比如部分招聘 AI 系统会记录 “业务部门拒绝候选人的原因”,并据此调整后续匹配权重,这种 “自优化” 能力也是评估效果的重要参考。

04 评估保障:系统的易用性与企业实际需求的契合度

即使招聘 AI 系统功能强大,若易用性差、不符合 HR 操作习惯,也难以发挥实际效果。因此,“易用性” 与 “需求契合度” 是评估效果的保障维度,直接影响系统的落地使用率。

评估易用性时,可从 HR 日常操作出发:系统界面是否清晰,关键功能(如简历查看、数据统计)是否能在 3 步内找到;是否支持与企业现有工具(如 OA、即时通讯软件)联动,避免 HR 在多系统间切换;是否提供简单的操作指引,新员工能否快速上手。

需求契合度则需结合企业规模与行业特性:中小型企业可能更关注 “基础筛选 + 流程自动化”,而集团型企业可能需要 “多子公司招聘管控”“跨区域数据协同” 等功能;制造业蓝领招聘需系统支持 “基础信息快速采集”,互联网企业技术岗招聘则需 “技能测评与 AI 面试联动”。若系统功能与企业需求不匹配,即使技术先进,也无法创造实际价值。

以 Moka 招聘 AI 系统为例,其支持 “自定义招聘流程” 与 “对话式 BI 数据统计”,HR 可根据岗位需求调整筛选规则,同时通过自然语言查询 “本月社招到岗率”“校招简历来源分布” 等数据,这种 “功能贴合需求 + 操作便捷” 的设计,提升了系统的实际落地效果。

FAQ:招聘 AI 系统效果评估常见问题

Q1:评估招聘 AI 系统效果时,是否需要关注 “AI 技术先进性”?

无需过度追求技术术语,核心应关注 “技术能否解决实际问题”。比如 “自然语言处理技术” 好不好,最终要看简历解析准确率;“机器学习模型” 优不优,要看匹配候选人的实际质量。即使系统提及 “多模态融合”“大模型支持”,若无法提升招聘效率或匹配精准度,也不代表效果好。

Q2:企业刚引入招聘 AI 系统,短期内如何快速评估效果?

短期内可聚焦 “核心痛点是否缓解”:若原本 HR 每天需花 4 小时筛选简历,引入系统后缩短至 1 小时,且筛选结果未出现明显偏差,说明系统在 “效率提升” 上已初见效果;若原本校招初筛易出现 “标准不统一” 问题,引入系统后各部门初筛标准一致,说明系统在 “流程规范化” 上发挥了作用。

Q3:不同行业的企业,评估招聘 AI 系统效果的重点是否有差异?

是的。比如零售行业门店招聘需关注 “系统能否快速处理分散的简历(如门店推荐简历)”,金融行业需关注 “系统数据合规性与候选人背景核查辅助能力”,教育行业则需关注 “教师岗位的‘教学能力’等隐性需求匹配”。评估时需结合行业招聘特性,而非套用统一标准。

Q4:若招聘 AI 系统效果未达预期,是否需要直接替换?

建议先复盘问题根源:是 “筛选规则设置不合理”“岗位需求未准确录入”,还是 “系统功能确实无法满足需求”。多数情况下,通过调整规则、优化岗位 JD 描述,可提升系统效果;若确因功能不匹配导致效果差,再考虑是否替换。

本文围绕 “招聘 AI 系统效果如何评估”,从功能有效性、流程效率与适配性、人才匹配转化、易用性与需求契合度四个维度,拆解了评估框架,并解答了常见疑问,帮助企业避开 “重技术轻实用” 的误区。HR 应立即行动:先梳理企业招聘核心痛点(如简历筛选慢、匹配不准),再对照本文框架评估现有系统,或在选型时聚焦 “需求契合” 而非 “功能堆砌”。若需进一步了解如何结合岗位特性优化评估逻辑,可通过 Moka 官网的试用通道,体验其贴合 HR 工作场景的招聘 AI 功能,辅助科学评估。